当前位置:网站首页>学习笔记3--规划控制中的机器学习基本思想

学习笔记3--规划控制中的机器学习基本思想

2022-07-17 14:21:00 【FUXI_Willard】

本系列博客包括6个专栏,分别为:《自动驾驶技术概览》、《自动驾驶汽车平台技术基础》、《自动驾驶汽车定位技术》、《自动驾驶汽车环境感知》、《自动驾驶汽车决策与控制》、《自动驾驶系统设计及应用》。

此专栏是关于《自动驾驶汽车决策与控制》书籍的笔记.

3.规划控制中的机器学习基本思想

机器学习算法大致分为:监督学习(如回归、分类),非监督学习(如聚类、降维)和强化学习;

3.1 强化学习

- 强化学习关注的是智能体如何在环境中采取一系列行为,从而获得最大的累积回报;一个智能体应该知道在什么状态下应该采取什么行为;强化学习是从环境状态到动作的映射的学习,通常把这个映射称为策略(Policy);

- 强化学习常用术语:

- Agent:指训练中的个体,即训练的算法和参数的集合;

- Environment:指Agent所处的环境;

- Episode:指一个完整的训练阶段;从一次训练开始,到这次训练成功或失败结束,是一个Episode;

- Step:指一个Episode当中的操作,每采取一次操作,就是一个Step;

- State:指Agent在每个时刻所面临的状态;

- Action:指采取的操作究竟是什么;

- Value:指当前时刻所能采取的各个动作所具有的价值;

- 策略(Policy)

- Policy定义了Agent在特定的时间、特定的环境下的行为方式,可以视为从环境状态到行为的映射,常用 π \pi π来表示;

- Policy分为两类:确定性的Policy(Deterministic Policy), a = π ( s ) a=\pi(s) a=π(s);随机性的Policy(Stochastic Policy), π ( a ∣ s ) = P [ A t = a ∣ S t = t ] \pi(a|s)=P[A_t=a|S_t=t] π(a∣s)=P[At=a∣St=t],其中, t t t是时间点, t = 0 , 1 , 2 , … , S t ∈ S t=0,1,2,\dots,S_t\in{S} t=0,1,2,…,St∈S, S S S是环境状态的集合, S t S_t St代表时刻 t t t的状态, A t ∈ A ( S t ) A_t\in{A}(S_t) At∈A(St), A A A是在状态 S t S_t St下的行为的集合, A t A_t At代表时刻 t t t的行为;

- 回报信号(Reward Signal)

- Reward是一个标量值,是每个Time Step中环境根据Agent的行为返回给Agent的信号,Reward定义了在该情境下执行该行为的好坏,Agent可以根据Reward来调整自己的Policy,Reward常用R表示;

- 值函数(Value Function)

- Reward定义的是当下的收益,而Value Function定义的长期的收益,可以看作是累计的Reward,常用v表示;

3.2 监督学习与非监督学习

- 监督学习是从一个已经标记的训练集中进行学习,训练集中每一个样本的特征可以视为是对该情景的描述,而其标记可以视为是应该执行的正确的动作;

- 非监督学习的目的视为从一堆未标记样本中发现隐藏的结构;

注:仅为简述,请自行详细学习机器学习内容。

边栏推荐

- LOJ 2324 - "Tsinghua training 2017" small y and binary tree

- Performance optimization @contented to reduce pseudo sharing

- An error, uncaught typeerror: modalfactory is not a constructor

- Configuration of vscode+unity3d

- NVIDIA uses AI to design GPU: the latest H100 has been used, which reduces the chip area by 25% compared with traditional EDA

- 微服务上线规范

- Play with the one-stop scheme of cann target detection and recognition

- How can enterprise telecommuting be more efficient?

- To get to the bottom: Principle Analysis of Objective-C correlation attribute

- Deep Learning for Generic Object Detection: A Survey-论文阅读笔记

猜你喜欢

![Some methods of early MCU encryption [get data in the comment area]](/img/14/8e1dcb799d8a3c0aefcac09be9dc51.png)

Some methods of early MCU encryption [get data in the comment area]

leetcode-08

Unity3d 模型中心点的转换(源代码)

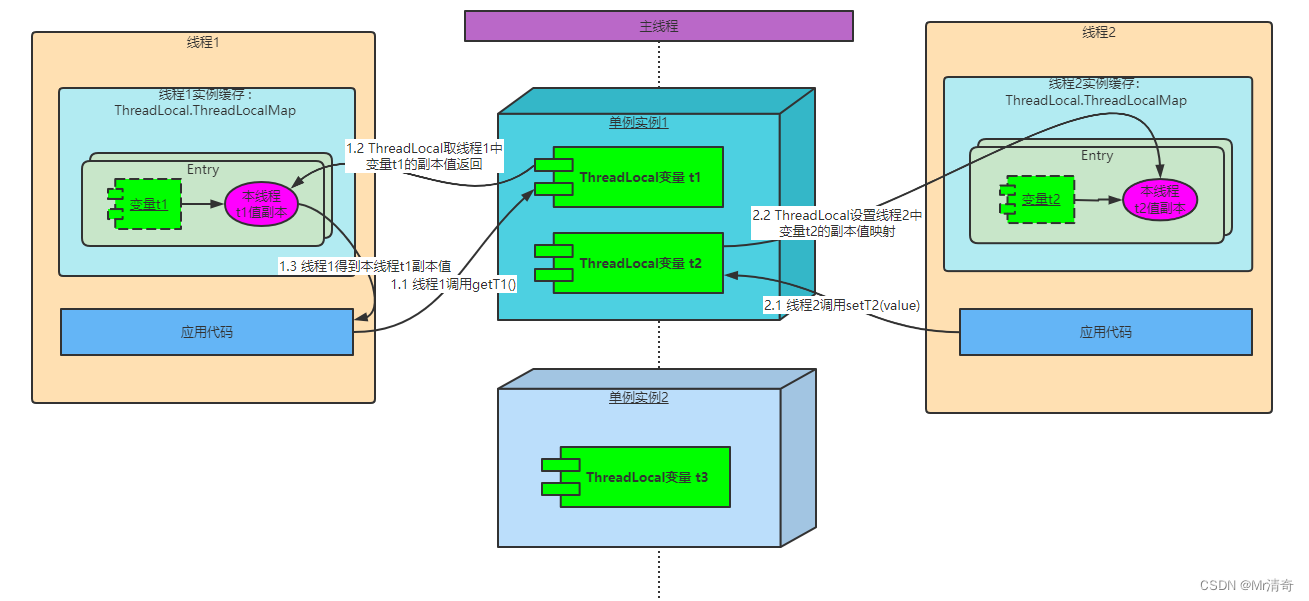

ThreadLocal变量使用及原理

LeetCode 745. Prefix and suffix search

Unity3d 读取mpu9250 例子原代码

Avi Deployment Guide (2): overview of AVI architecture

A fastandrobust volutionalneuralnetwork based defect detection model inproductqualitycontrol reading notes

(1) Learn about MySQL

Performance optimization @contented to reduce pseudo sharing

随机推荐

Play with the one-stop scheme of cann target detection and recognition

Satellite network capacity improvement method based on network coding

Keras深度学习实战(14)——从零开始实现R-CNN目标检测

8. Fixed income investment

Environment variable configuration of win10

Similarities and differences between OA system and MES system

Introduction to sap appgyver

Avi Deployment Guide (2): overview of AVI architecture

Google Earth engine - Hansen global forest change v1.8 (2000-2020) forest coverage and forest loss data set

Qt--优秀开源项目

Download of common getshell tools

2022/7/15

leetcode-08

8.固定收益投资

性能优化之@Contended减少伪共享

A fastandrobust volutionalneuralnetwork based defect detection model inproductqualitycontrol reading notes

Input number pure digital input limit length limit maximum value

华为无线设备配置频谱导航

Pytoch and weight decay (L2 norm)

Nombre d'entrées nombre d'entrées numériques pures limite de longueur maximale